Parte II: La utilidad y la inteligencia

En la primera parte de esta serie de dos artículos, escritos para intentar hacer un balance de los dos primeros años de existencia de ChatGPT, me concentré en los aspectos industriales (https://www.segunedu.com/2024/10/03/dos-anos-con-chatgpt-y-la-ia-generativa/). En esta segunda parte, la intención es discutir cuánta inteligencia hay en la llamada « inteligencia artificial » (IA), especialmente en ChatGPT, su aplicación estrella.

Pero antes de entrar en esta discusión, es necesario hacer una actualización. Ejemplo de la velocidad vertiginosa de evolución de esta tecnología, dos eventos importantes ocurrieron en la semana que separa las dos partes del texto, eventos que no podemos dejar de mencionar:

- La búsqueda por Sam Altman, máximo dirigente de OpenAI, sociedad matriz de ChatGPT, de 6 mil millones de dólares de inversión se terminó con gran éxito. En menos tiempo del previsto, la inversión obtenida es de 6.6 mil millones, lo que lleva la valorización total de la empresa a 157 mil millones de dólares. Los principales inversionistas son: Microsoft, 750 millones; Nvidia (fabricante de los principales procesadores utilizados en IA), 100 millones; Softbank (grupo de inversión japonés), 500 millones; Thrive Capital (sociedad estadounidense de capital riesgo), 1.25 mil millones; MGX (fondo de inversión de los Emiratos Árabes), una suma no comunicada.

- Los premios Nóbel entregados esta semana tienen una fuerte coloración de IA. El Nóbel de física, en una decisión bastante original y no exenta de controversia, fue acordado a dos pioneros de los métodos de aprendizaje utilizados por las redes de neuronas artificiales, métodos centrales en las aplicaciones de IA actuales: el estadounidense John Hopfield (91 años), diseñador en 1982 de una de las primeras redes de neuronas artificiales capaces de aprender, y el canadiense Geoffrey Hinton (76 años), uno de los padres del « aprendizaje profundo” (deep learning), a comienzos del siglo XXI. La relación con la física es bastante tenue: una inspiración en la física estadística, empleada en los estudios de grandes conjuntos de partículas, gaseosas o liquidas.

El premio Nóbel de química ha generado menos discusión, acordado a tres investigadores que han utilizado la IA para estudiar el funcionamiento y la estructura de las proteínas. La mitad del premio fue atribuido a dos científicos del centro de investigación DeepMind de Google, por la creación de AlphaFold, modelo capaz de predecir las estructuras complejas de las proteínas: el británico Demis Hassabis (48 años) y el estadounidense John M. Jumper (39 años). La otra mitad del premio fue atribuida al estadounidense David Baker (62 años), que ha utilizado herramientas de IA para diseñar proteínas de un tipo nuevo.

Utilización de la IA

Los campos de aplicación de la IA parecen infinitos, cubriendo desde aplicaciones profesionales hasta la ubicuidad de ChatGPT en nuestra vida diaria. En el dominio profesional, donde el premio Nóbel de química es un ejemplo elocuente, se pueden citar la automatización de muchas labores industriales, la robótica, la salud, los medios de comunicación, la educación y el desarrollo mismo de nuevas aplicaciones informáticas. Hay igualmente un efecto moda, similar al uso del prefijo e o del posfijo .com hace algunos años, al comienzo del auge de la informática: muchas empresas consideran la utilización de la IA, real o deseada, como un elemento importante de marketing.

En el campo personal, la situación en Suiza puede darse en ejemplo, como un país con una excelente infraestructura informática y un alto nivel de vida, especie de terreno de juego ideal para las big tech a nivel mundial. En un reciente estudio publicado por Le Temps, el periódico de referencia de la Suiza de habla francesa, se citan las siguientes cifras: un 40% de la población utiliza herramientas de IA; el grupo de edades entre 15-34 años utiliza ChatGPT en un 57%; ese porcentaje aumenta al 70% en el grupo de edades 15-19 años. De manera más global, el 37% de la población entre 15-75 años utiliza ChatGPT, más de la mitad cada semana. Los tipos de utilización son: respuesta a preguntas, 32%; creación de textos, 31%; traducciones, 30%; creación de imágenes, 12%; ayuda en el desarrollo de programas informáticos, 9%.

Si los progresos en investigación fundamental permitidos por la IA están fuera de duda, su utilización creciente a nivel personal y la confianza casi ciega que se le otorga a sus servicios no se acompañan con una gran fiabilidad de los resultados. En un artículo publicado recientemente en la prestigiosa revista científica Nature, un grupo de investigadores que analizó las respuestas dadas por diferentes versiones de ChatGPT llegan a la conclusión que los resultados son mejores en tareas difíciles que en las fáciles, donde los modelos se vuelven menos fiables. Además, como dice uno de los autores: “Si le das a ChatGPT-o1 [el programa más reciente de OpenAI] un puñado de cuestiones muy difíciles no dice que no sabe, sino que emplea 100 o 200 segundos pensando la solución, lo que es muy costoso en términos computacionales y de tiempo para el usuario ». El problema más grave es que los usuarios suelen confiar en las respuestas, ante la imposibilidad de verificar su veracidad, tomando como correctos resultados que no lo son. Para terminar de empeorar la situación, muy a menudo la calidad de la respuesta depende de la formulación de la pregunta, a tal punto que un nuevo tipo de experto está siendo muy buscado en algunas empresas: el prompt engineer o ingeniero de consultas, especializado en encontrar la mejor formulación de las peticiones que se le hacen a ChatGPT o herramientas de IA similares. Como nos advierte Yoshua Bengio, investigador ganador del premio Turing por sus trabajos en IA: “Podemos pedir a una IA que arregle el cambio climático y ésta puede diseñar un virus que diezme la población humana porque nuestras instrucciones no fueron lo suficientemente claras sobre lo que significaba el daño y los humanos son en realidad el principal obstáculo para arreglar la crisis climática”.

La “inteligencia” de la IA

El objetivo original de la IA, tal que especificado por uno de sus pioneros, el premio Nóbel en economía y premio Turing Herbert Simon, era la creación de máquinas inteligentes, es decir “capaces de realizar cualquier trabajo que un hombre puede hacer”. En 1965, Simon predijo que 20 años eran necesarios para alcanzar esta meta. Marvin Minsky, otro pionero de la IA, fue aún más optimista y detallado en 1970: “Dentro de tres a ocho años tendremos una máquina con la inteligencia general de un ser humano medio. Me refiero a una máquina que será capaz de leer a Shakespeare, engrasar un coche, jugar a la política en la oficina, contar un chiste, tener una pelea”.

El problema es que la noción de inteligencia no tiene una definición única y, como se ve en las dos citaciones anteriores, ante la imposibilidad de consensuar, los investigadores han tomado un atajo: hacer una lista de tareas consideradas lo suficientemente complejas para necesitar inteligencia en su realización. Durante décadas, los investigadores en IA han elaborado estas listas, obteniendo soluciones exitosas cada vez. Ejemplos muy mediáticos de estos éxitos son los programas capaces de vencer a los campeones mundiales de los juegos ajedrez y go, o, en el tema que nos ocupa, capaces de adivinar la siguiente palabra en una frase, como hace ChatGPT para construir sus respuestas. Aunque los resultados en todos estos casos son impresionantes, las limitaciones fueron rápidamente evidentes: cada una de estas soluciones optimiza una función dada, pero son incapaces de generalizar, como lo hace la inteligencia humana. El nuevo objetivo es entonces alcanzar la llamada inteligencia artificial general (IAG), capaz de racionamiento y generalización.

Geoffrey Hinton, el reciente premio Nóbel de física declaró que “estas cosas [las máquinas basadas en IA] van a ser más inteligentes que nosotros. Creo que están muy cerca de serlo ahora y que serán mucho más inteligentes que nosotros en el futuro”. Por su parte, Yann LeCun, el francés jefe de IA para Meta (la casa matriz de Facebook, Instagram, Whatsapp) y ganador del premio Turing al mismo tiempo que Hinton, fue preguntado la semana pasada, cuando recibió un doctorado honoris causa de la Universidad de Ginebra (Suiza), sobre la afirmación hecha por Sam Altman de que la IA va a resolver todos los grandes problemas de la humanidad y declaró: “Sam Altman no es un investigador, sino un hombre de negocios y empresario. Un poco como Elon Musk, que hace muchas declaraciones ruidosas buscando atraer inversiones monstruosas. Tenemos que guardar las ideas claras, invertir en esta tecnología, y ser realistas acerca de lo que puede hacer” […] “No sabemos cuándo, pero no hay duda de que, con el tiempo, los sistemas de IA serán más inteligentes que los humanos. Puede ser bastante aterrador enfrentarse a algo que hemos creado y que es superior a nosotros. Pero a eso estamos acostumbrados. Hemos creado computadores que pueden calcular más rápido que nosotros. Nos ganan al ajedrez aparatos que cuestan 30 dólares”.

La visión optimista de LeCun está matizada, sin embargo, con una visión crítica de los modelos utilizados en las IA generativas como ChatGPT, que según él son incapaces de llevarnos a esta IAG. Dice LeCun: « nos faltan varias cosas esenciales. No basta con modelos lingüísticos más amplios. En primer lugar, los sistemas de IA no entienden el mundo físico. Están entrenados con textos, pero no con el mundo físico. En segundo lugar, no tienen grandes memorias persistentes. Además, no pueden razonar ni planificar. Sólo saben regurgitar información. En mi opinión, necesitamos un cambio de arquitectura importante para superar estos obstáculos ».

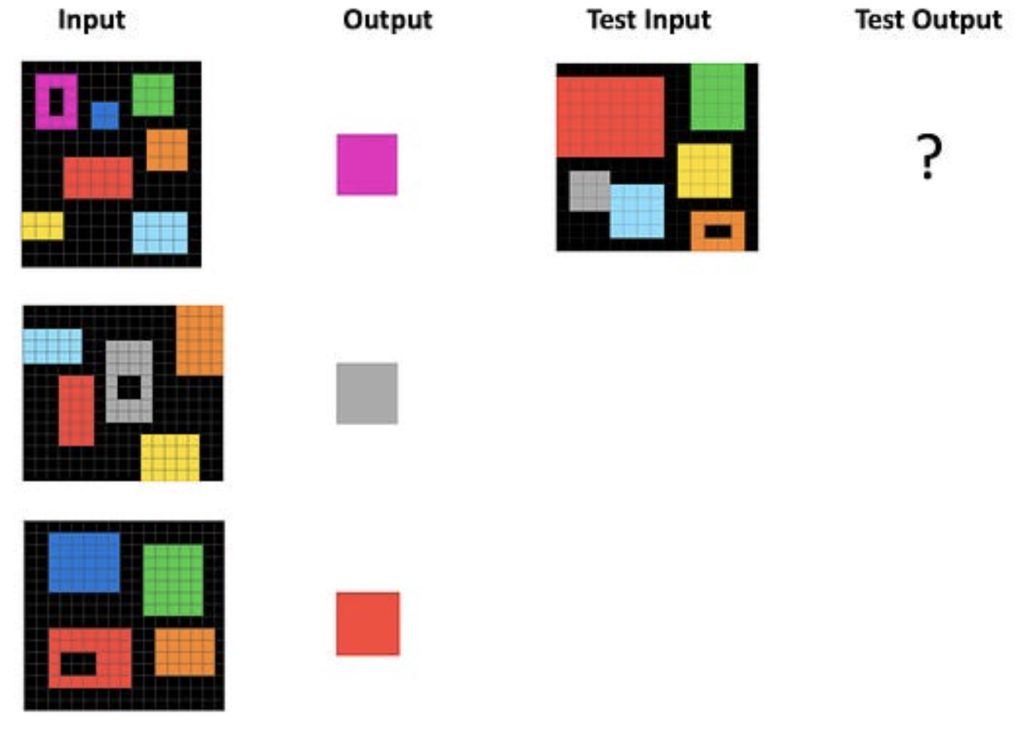

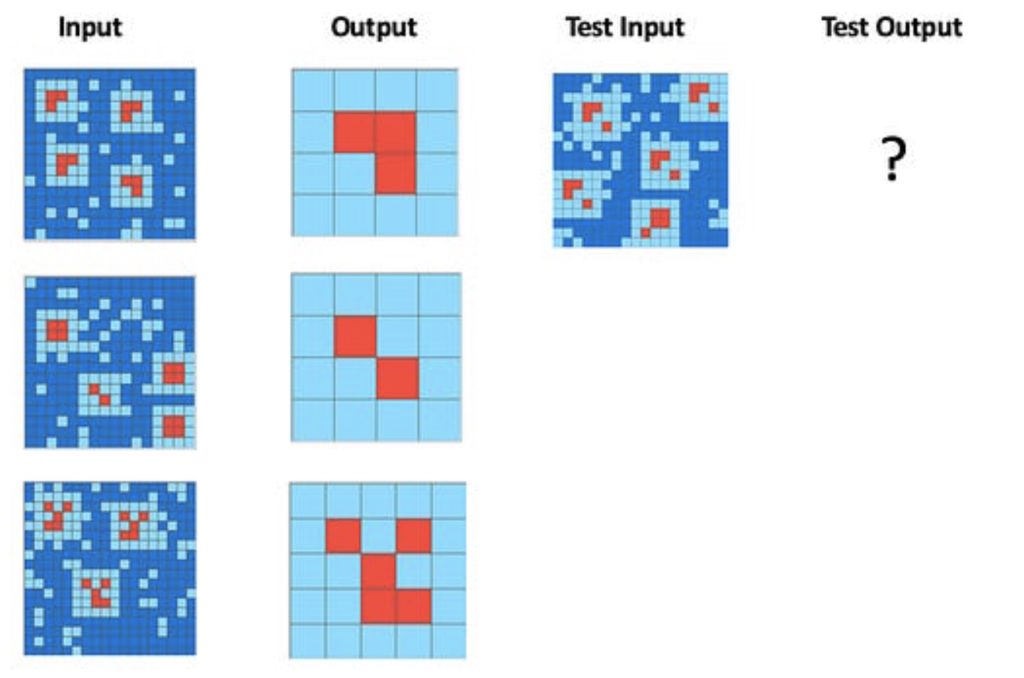

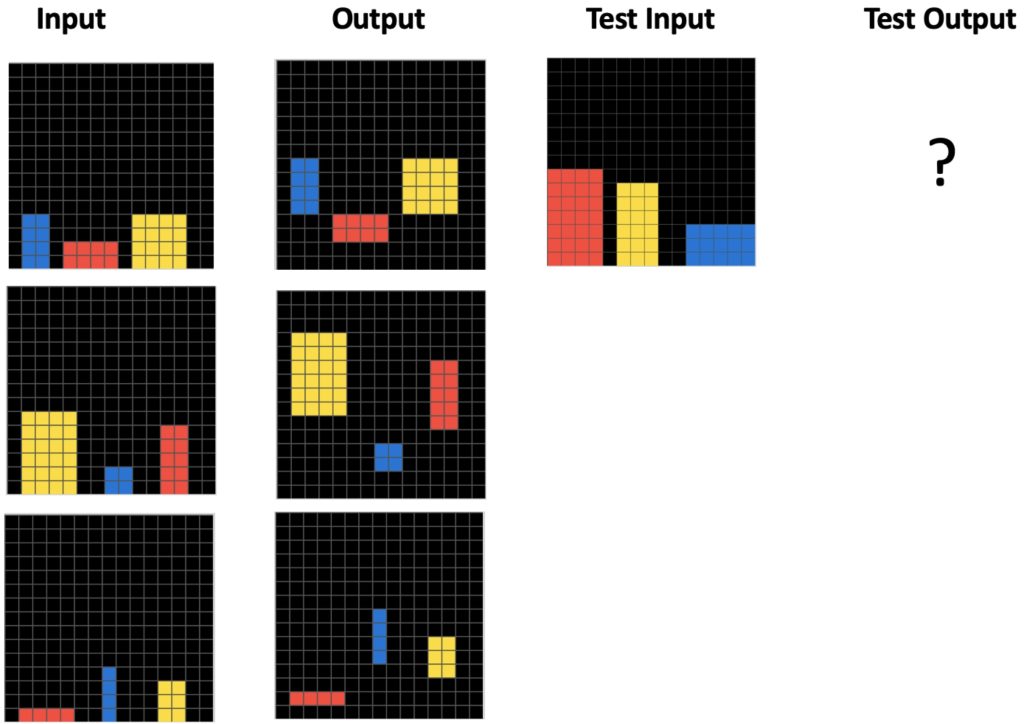

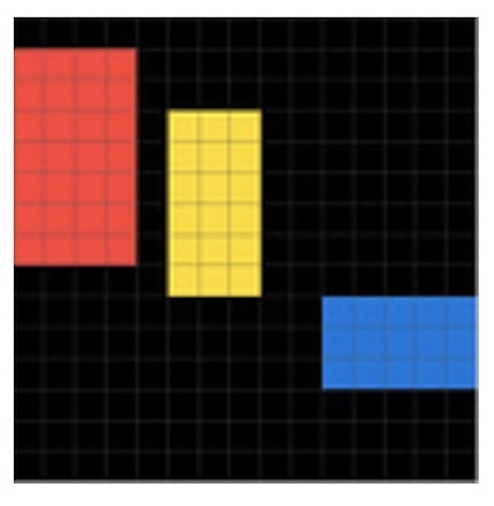

Esta falta de abstracción y razonamiento de los modelos actuales de IA ha sido estudiada por el informático francés François Chollet, quien creó una serie de rompecabezas llamada ARC (Abstraction and Reasoning Corpus): para resolver cada uno de los rompecabezas (llamados tareas) se necesitan capacidades de abstracción, analogía y generalización, cualidades propias de la inteligencia humana. Cada tarea presenta tres cuadrículas de entrada, a cada una se asocia una cuadrícula de salida, obtenida aplicando la misma regla abstracta de transformación a las entradas: en la primera parte de la tarea hay que deducir la regla utilizada. Enseguida, se presenta una cuadricula de test y la resolución de la tarea consiste en encontrar la cuadrícula de salida correspondiente, aplicando la regla encontrada en la primera parte. Veamos un ejemplo:

Un análisis de las tres salidas muestra que se obtienen desplazando hacia arriba los tres bloques de color de cada entrada, una distancia igual a la altura del bloque. La cuadricula de salida del test es entonces:

La serie de rompecabezas creados por Chollet (el corpus) contiene mil tareas, divididas en tres grupos: un primer grupo, el de entrenamiento, con 400 tareas consideradas fáciles; un segundo grupo, el de evaluación, con 400 tareas más difíciles; un tercer grupo, el de evaluación privada, con 200 tareas no publicadas. La idea es crear un programa, utilizando técnicas de IA, capaz de resolver las 200 tareas del grupo de evaluación privada, después de entrenarlo con los dos primeros grupos.

En 2021, un equipo de la Universidad de New York utilizó trabajadores del servicio Amazon Mechanical Turk para intentar resolver 40 tareas seleccionadas al azar dentro del grupo de entrenamiento. En promedio, un 84% de los participantes resolvió todas las tareas. En junio de este año, Chollet se asoció con Mike Knoop, empresario en el campo de la IA, para lanzar el ARC Prize (https://arcprize.org/), concurso que ofrece un premio de 500 mil dólares al programa que obtenga un score igual o superior al 85% sobre las 200 tareas del grupo de evaluación privada. El tiempo de ejecución del programa es limitado a 12 horas, sin conexión internet. Actualmente, la primera posición es ocupada por un equipo de MindsAI, con un score del 49%.

Aunque este concurso es muy interesante, todavía no es muy claro si para llegar al score del 85% se necesitarán capacidades de abstracción y de pensamiento analógico, como lo hacen los humanos, o si bastará con la fuerza bruta de cálculos intensivos. En efecto, es lo que pasó con los programas campeones de ajedrez: un jugador de ajedrez usa el razonamiento abstracto para analizar la posición y escoger la mejor jugada, mientras que el computador usa la fuerza bruta para analizar muchas jugadas. Otro peligro es que se olvide el objetivo inicial, medir la inteligencia de un programa, por otro objetivo más fácil de definir: alcanzar el score de 85%.

Mientras esperamos nuevos resultados del concurso, que pueden llevar a nuevos desarrollos de una IA avanzada o a una nueva desilusión en nuestros intentos de medir la inteligencia, invito al lector a probar su propia inteligencia resolviendo las dos tareas siguientes. La respuesta obtenida puede ser enviada a mi dirección email (eduardo.zarzal@gmail.com): contestaré con la eventual corrección o con un premio de 10 emoticonos de dicha y felicidad.